当前位置:首页

> robots.txt

robots.txt怎么设定?如何禁止搜索引擎爬取网站?

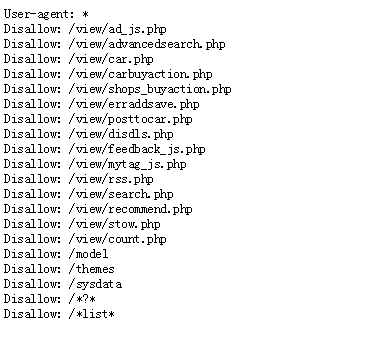

robots.txt 的主要功用在于,告诉搜索引擎某个页面是否应该爬取?当你在你的网站上加入robots.txt 这个档案,你就可以告诉搜索引擎(例:Google 搜索引擎),网站上哪些网址是可以爬取的,而哪些网址又是不可以爬取的。robots.txt这个档案主要用来避免网站因要求过多而超...

robots.txt协议文件写法

robots.txt文件是引导搜索引擎Spider抓取网站的文件。合理地使用robots.txt文件可以防止自己网站内诸如后台登入之类的秘密页面被搜索引擎抓取索引和公布,还可以屏蔽搜索引擎对网站非内容页面的抓取,值让搜索引擎抓取和收录能够带来排名和流量的页面。很多建站系统,在建成网站后,都网站根目录...

如何使用robots.txt阻止搜索引擎爬(抓取)你的网站?

为了你的网站可以被别人搜寻到,搜寻引擎爬虫,有时也称为搜寻机器人(bots)或是搜寻蜘蛛(spiders),会爬取你的网站,搜寻有变动的内容并且重新更新搜寻引擎的搜寻检索。如何用robts.txt 这个档桉去控制搜寻蜘蛛网站站长可以使用robots.txt这个文件,来指导搜寻蜘蛛应该如何爬取这个网站...

教你如何正确设置使用robots.txt文件

各位站长朋友都知道网站Robots.txt文件,所谓的Robots.txt文件就是网站根目录下面的纯文本文件,是蜘蛛索引网站时第一个要读取的文件,它用于指定spider在您网站上的抓取范围,当网站中有不需要被蜘蛛抓取的内容时,可以使用robots.txt文件加入屏蔽,以免增加网站蜘蛛的抓取难度。所以...